Sommario

In un contesto di straordinario e rapidissimo sviluppo tecnologico, l’intelligenza artificiale (IA) irrompe nella routine personale e lavorativa di tutti noi con la promessa di grandi benefici per chi voglia valorizzarla per i propri scopi e interessi. Se da una parte i risvolti positivi sono innegabili, dall’altra è palese come l’utilizzo improprio dell’IA possa avere un impatto significativo nel mondo reale se non si applicano adeguate misure di controllo. Infatti, la strategia che l’IA adotta nel prendere decisioni, specialmente nel caso dei recenti modelli generativi del linguaggio, non è direttamente controllabile dall’essere umano e potenzialmente dipende dallo scenario in cui l’IA è adottata, determinando potenziali rischi di sicurezza con possibili ripercussioni anche sull’incolumità fisica delle persone. In questo articolo, dopo aver introdotto i fondamenti del cosiddetto ecosistema dell’IA, analizzeremo nel dettaglio i macro-processi di governo dell’IA finalizzati a garantire la cybersicurezza dell’ecosistema stesso, dalla gestione di rischi cibernetici introdotti dall’IA ai programmi di ricerca ed innovazione sul tema, sulla base del contesto italiano. Descriveremo, inoltre, alcuni casi d’uso notevoli in cui l’IA rappresenta un supporto per la cybersicurezza, prima di concludere con alcuni spunti sui possibili sviluppi futuri.

Abstract

In a context of extraordinary and incredibly fast-paced development, artificial intelligence (AI) breaks into the daily routine of all of us, pledging to bring great benefits to those who want to exploit it. If on the one hand the positive aspects are undeniable, on the other hand it is clear how an improper use of AI can have a significant impact in the real world if adequate security controls are not enforced. Indeed, the strategy the AI adopts in making decisions, especially in the case of recent generative language models, is not directly under human control, and potentially depends on the specific scenario in which AI is applied, yielding possible non-negligible security and safety concerns. In this article, after having introduced the fundamentals of the so-called AI ecosystem, we will analyze in detail the AI governance macro-processes aimed at guaranteeing the cybersecurity of the ecosystem itself, ranging from the management of cyber-risks introduced by AI to research and innovation programs, focusing on the Italian setting. We will also describe some notable use cases where AI comes in support of cybersecurity, before concluding with some insights into possible future developments in this field.

Keywords

artificial intelligence, machine-learning, cybersecurity, risk management, certification, standards, regulation, innovation, use cases, critical infrastructures, security operations centers, counter-AI.

Introduzione

Le sorprendenti prestazioni raggiunte recentemente dai modelli generativi del linguaggio (large language model, LLM) alla base di prodotti quali, ad esempio, ChatGPT e Bard, hanno contribuito a far salire l’intelligenza artificiale (IA) alla ribalta dell’opinione pubblica. La dirompente evoluzione tecnologica dell’IA, fino a pochi mesi fa percepita principalmente dagli addetti ai lavori, comincia ad impattare su diversi aspetti della vita quotidiana, sia in ambito privato che lavorativo. Le imprese spingono sempre di più per l’adozione di soluzioni di IA (cfr. Figura 1), principalmente nell’ottica della riduzione dei costi, dell’efficientamento della collaborazione tra diverse funzioni di business e per scoprire nuove potenzialità di fare profitti. Tuttavia, a fronte delle tante possibilità di utilizzo dell’IA, emergono anche nuove e significative minacce e sfide che richiedono investimenti dedicati da parte delle istituzioni nazionali e sovranazionali.

A livello governativo, l’AI Safety Summit ha riunito, per la prima volta, 28 Paesi e l’Unione Europea a Bletchley Park nel Regno Unito nel novembre del 2023, pervenendo ad una dichiarazione condivisa (“Bletchley Declaration on AI Safety”1) che riconosce l’urgente necessità di comprendere e gestire collettivamente i rischi potenziali dell’IA attraverso uno sforzo globale congiunto, per garantire che l’IA sia sviluppata e utilizzata in modo sicuro e responsabile a beneficio della comunità globale.

Il Presidente degli Stati Uniti d’America (USA) ha emanato un ordine esecutivo nell’ottobre 20232 con specifiche indicazioni finalizzate a rendere l’IA non pericolosa (in inglese, safe), sicura e affidabile, a dimostrazione dell’importanza e della strategicità degli investimenti sui sistemi di IA. Gli USA hanno altresì predisposto un programma strategico [2] e indicato un approccio basato sul “Blueprint for an AI Bill of Rights” [3], ovvero un insieme di principi e buone pratiche associate per governare lo sviluppo di sistemi automatizzati proteggendo i diritti e la sicurezza della società americana nell’era dell’IA.

L’Unione Europea (UE) ha anch’essa adottato una strategia [4] per gestire la ricerca e l’innovazione sull’IA, impegnandosi a perseguire un approccio all’IA che apporti benefici alle persone e alla società nell’insieme, attraverso un percorso che parte dall’individuazione delle applicazioni potenzialmente pericolose e di misure adeguate a tutelare l’affidabilità dei relativi sistemi. L’UE sta, inoltre, giungendo all’approvazione finale dell’AI Act33 , che, come dettagliato nella Sezione 3.3, costituirà la prima normativa mondiale in materia di intelligenza artificiale. Con riferimento agli aspetti di cybersicurezza in relazione all’IA, l’Agenzia dell’Unione Europea per la cibersicurezza (ENISA) ha avviato numerosi studi dedicati (ad esempio [5]).

Anche l’Italia ha elaborato un proprio programma strategico [6] sull’IA; tale programma è in corso di aggiornamento per tenere conto anche dei recenti sviluppi in materia di IA generativa. La strategia italiana è focalizzata, oltre che sulla ricerca, sullo sviluppo di applicazioni basate su IA a beneficio delle aziende e della pubblica amministrazione, e si appresta a recepire i regolamenti concepiti a livello europeo. Inoltre, l’Agenda di Ricerca e Innovazione per la Cybersicurezza [7] recentemente pubblicata dall’Agenzia per la Cybersicurezza Nazionale (ACN) riporta in maniera dettagliata svariati argomenti di ricerca concernenti l’IA e gli aspetti di cybersicurezza ad essa relativi.

Questo articolo ha l’obiettivo principale di chiarire la relazione tra IA e cybersicurezza al meglio delle conoscenze attuali in materia, concentrandosi su come governare i rischi dell’IA e su come sfruttare tale tecnologia per rafforzare la cybersicurezza in alcuni scenari notevoli. Il lavoro si focalizza sullo scenario nazionale italiano, pur fornendo un insieme di indicazioni e di spunti a carattere generale. Per raggiungere questo obiettivo, in Sezione 2 andremo anzitutto a rappresentare dove si inserisce la cybersicurezza nell’“ecosistema dell’IA”, inteso come insieme di oggetti, attori e ruoli rilevanti nei macro-processi di governo (governance) dell’IA in relazione alla cybersicurezza. Questi ultimi, saranno invece dettagliati in Sezione 3. In Sezione 4, proporremo dei casi d’uso notevoli di applicazione dell’IA nel contesto della cybersicurezza dei sistemi. Concluderemo l’articolo in Sezione 5, evidenziando aspetti di rilievo ed indicando possibili sviluppi futuri.

La cybersicurezza nell’ecosistema dell’IA

Le dimensioni dell’IA&Cybersicurezza

Esistono molteplici declinazioni della relazione tra cybersicurezza e IA, trattandosi di una interazione complessa che può articolarsi in diverse direzioni. Nel seguito identifichiamo le tre che riteniamo di principale interesse:

1. cybersicurezza dell’IA. L’integrazione dell’IA nei sistemi informatici e nelle reti può introdurre nuove minacce. In particolare, alcuni attacchi tipici perpetrati ai danni di tali sistemi hanno ad oggetto la deduzione o l’estrazione di informazioni circa i modelli di IA o i dati utilizzati per il loro addestramento, oppure l’obiettivo di ingannare o eludere il funzionamento dei sistemi durante la fase di addestramento o di inferenza, al fine di influenzarne le previsioni o indurre comportamenti non desiderati, come ad esempio far riconoscere come sicuri oggetti pericolosi.

La cybersicurezza dell’IA comporta un importante aspetto di governo dei rischi e, come enucleato in Sezione 3.1, rende necessario stabilire processi e procedure di cybersecurity by design in ogni fase dello sviluppo dei sistemi, dalle fasi di definizione dei modelli di IA, alla progettazione delle procedure di apprendimento, all’implementazione e test e in particolare alla fase di messa in produzione (deployment) finale del sistema, nonché nel monitoraggio e controllo dei sistemi in esercizio. Inoltre, in relazione alle dimensioni di cybersicurezza da considerare nel processo di governo dei rischi, è importante prendere in esame aspetti di cybersicurezza che sconfinano nella affidabilità (trustworthiness), quali la sicurezza fisica (safety), la trasparenza (transparency), la spiegabilità (explainability) e il governo dei dati (considerando gli aspetti di qualità dei dati e della loro protezione);

2. IA a supporto della cybersicurezza. L’IA utilizzata per realizzare strumenti avanzati di cybersicurezza e per facilitare gli sforzi delle autorità per rispondere meglio alla criminalità informatica e delle imprese per proteggere i propri sistemi. In particolare, la capacità dell’IA di identificare schemi e apprendere in modo adattivo in tempo reale può velocizzare i processi di rilevamento, contenimento e risposta agli incidenti. In questa accezione rientrano i sistemi di IA “contro-IA” (“counter-AI”), ovvero soluzioni innovative basate su IA per rilevare, prevenire e mitigare le minacce provenienti da agenti automatizzati che utilizzano l’IA per attaccare e danneggiare reti, sistemi informatici e infrastrutture;

3. IA per scopi offensivi. Le capacità adattive dell’IA possono essere utilizzate per sviluppare strumenti di attacco più sofisticati, persistenti e difficili da rilevare. L’uso dell’IA può inoltre aumentare la potenza e la scala degli attacchi informatici. In particolare, la recente evoluzione dei modelli generativi del linguaggio permette di generare in modo massivo contenuti falsi che sembrano autentici. Questa possibilità, nelle mani di attori malevoli rende possibile automatizzare (tipicamente a basso costo) attacchi su larga scala quali campagne di disinformazione, spam e phishing.

Nel seguito, faremo sinteticamente riferimento alle tre direzioni esposte con la locuzione “IA&Cybersicurezza” e, propedeuticamente all’analisi delle connotazioni illustrate, partiremo dal definire cos’è l’IA e descrivere nel dettaglio il suo ecosistema, chiarendo in particolare i concetti di oggetti, attori e ruoli che lo compongono.

Definizioni

La definizione di “intelligenza artificiale” è tuttora dibattuta [4]. Una definizione [8] elaborata dall’ High-Level Expert Group (HLEG) europeo sull’intelligenza artificiale4 si riferisce ai sistemi di IA nei termini di “sistemi software (e possibilmente anche hardware) progettati dagli esseri umani che, dato un obiettivo complesso, agiscono nella dimensione fisica o digitale percependo il loro ambiente attraverso l’acquisizione di dati, interpretando i dati raccolti strutturati o non strutturati, ragionando sulla conoscenza o elaborando le informazioni derivate da questi dati e decidendo le migliori azioni da intraprendere per raggiungere l’obiettivo stabilito. I sistemi di IA possono utilizzare regole simboliche o apprendere un modello numerico, e possono anche adattare il loro comportamento analizzando come l’ambiente è influenzato dalle loro azioni precedenti.”

In Figura 2, proponiamo una rappresentazione dell’ecosistema dell’IA&Cybersicurezza in termini di oggetti, attori e ruoli e la relazione con i principali filoni operativi (i c.d. macro-processi di governo), finalizzati a raggiungere i tre obiettivi (protezione, risposta e sviluppo) della Strategia Nazionale di Cybersicurezza [9] in tale contesto. Tra tutti i soggetti pubblici e privati partecipanti all’ecosistema, la figura evidenzia le funzioni ricoperte dai soggetti dell’architettura nazionale di cybersicurezza.

Oggetti

Consideriamo i seguenti tre oggetti nell’ecosistema.

• Il modello di IA è il “cuore” dell’IA, una rappresentazione matematica o algoritmica progettata per svolgere compiti specifici. Un modello è caratterizzato da una determinata architettura (a titolo d’esempio una rete neurale), che permette tipicamente l’identificazione di una relazione causale tra determinate caratteristiche (feature) presenti nei dati su cui si lavora, per prendere decisioni, fare previsioni o eseguire altre attività intelligenti; ad esempio, un modello di riconoscimento facciale è progettato per identificare volti nelle immagini. In Sezione 3.1, ci concentreremo in particolare sui modelli cosiddetti di apprendimento automatico (machine learning), ovvero quei modelli di IA che possono essere addestrati tipicamente su grandi quantità di dati per imparare a svolgere la loro funzione al meglio.

• Il sistema di IA è un insieme più ampio di componenti e moduli software e/o hardware, che realizzano una soluzione completa per un determinato scopo. Il sistema di IA può includere uno o più modelli di IA, ma anche interfacce utente, motori di ragionamento o database, eventualmente integrando sistemi hardware, sensori e attuatori per l’interazione con l’ambiente fisico o digitale [5]. Ad esempio, un assistente vocale include un modello di riconoscimento vocale, ma anche componenti per l’elaborazione del linguaggio naturale e l’interazione con l’utente.

• Il prodotto è un’applicazione, un dispositivo o un servizio che integra un sistema di IA nell’ambito delle sue funzionalità. Può essere ad esempio una applicazione mobile, un robot domestico, o qualsiasi altra cosa che utilizzi l’IA per i propri scopi. Ad esempio, un prodotto di traduzione automatica può utilizzare un sistema di IA con modelli di apprendimento automatico per tradurre testi in diverse lingue.

Segue un esempio a scopo illustrativo degli oggetti introdotti.

Esempio di sistema basato su un modello di machine learning: guida autonoma

A bordo di alcuni veicoli di ultima generazione (prodotti) sono presenti sistemi di guida autonoma basati su modelli addestrati su enormi quantità di dati di guida (questi dati, in virtù del loro ruolo nell’apprendimento, vengono anche chiamati “esempi”), che contengono immagini, video e altre informazioni relative alla strada e agli oggetti che si possono incontrare durante il tragitto per consentire ai sistemi di guida autonoma di interpretare e reagire alle condizioni della strada in tempo reale.

Quando il veicolo si mette in movimento, il sistema di IA acquisisce costantemente dati dal suo ambiente circostante attraverso telecamere e sensori. Questi dati includono immagini della strada, degli ostacoli, degli altri veicoli e delle persone presenti. Il modello di apprendimento automatico utilizza queste immagini per riconoscere e distinguere gli oggetti rilevanti per prendere decisioni sulla guida del veicolo. Attraverso l’analisi di milioni di esempi precedenti, il modello ha imparato a identificare e classificare oggetti comuni come auto, pedoni, biciclette e segnali stradali. Ad esempio, se rileva un semaforo rosso, il modello determina che è necessario fermarsi e attendere il verde. Se riconosce un pedone che sta attraversando la strada, il sistema deve attuare manovre evasive o rallentare per garantire la sicurezza.

Il modello di IA può continuare ad aggiornare le sue conoscenze e a perfezionarsi man mano che incontra nuove situazioni sulla strada. Con l’esperienza e il continuo apprendimento dai dati, il sistema di guida autonoma diventa sempre più affidabile ed efficiente nel fornire un output sicuro e accurato a partire dai dati di input acquisiti.

Attori

A fronte dei molteplici macro-processi di governo dell’IA&Cybersicurezza, che saranno illustrati in dettaglio nella Sezione 3, i principali attori che operano per la loro realizzazione sono:

• amministrazioni pubbliche;

• aziende private e professionisti;

• attori governativi quali autorità, enti e agenzie che per competenza sono coinvolte in processi di promozione, valutazione, monitoraggio di attività di cybersicurezza e/o di IA, tra i quali, in Italia, figurano principalmente i soggetti i soggetti dell’architettura nazionale di cybersicurezza [9];

• enti di ricerca e accademia;

• enti internazionali (partecipati unicamente da enti di normazione nazionali) e associazioni (partecipate, oltre che da enti di normazione nazionali, anche da Governi e aziende private) di normazione tecnica/standardizzazione che sviluppano norme tecniche per i prodotti.

Ruoli

I principali ruoli che gli attori sopra elencati possono incarnare sono riportati a seguire:

• certificatore;

• contrasto al crimine;

• emanatore di standard;

• gestore di incidenti e crisi;

• innovatore;

• legislatore;

• policy maker;

• vigilanza.

Nella sezione successiva, chiariremo la relazione dei vari ruoli con i principali filoni operativi nell’ambito dell’architettura di sicurezza nazionale cibernetica.

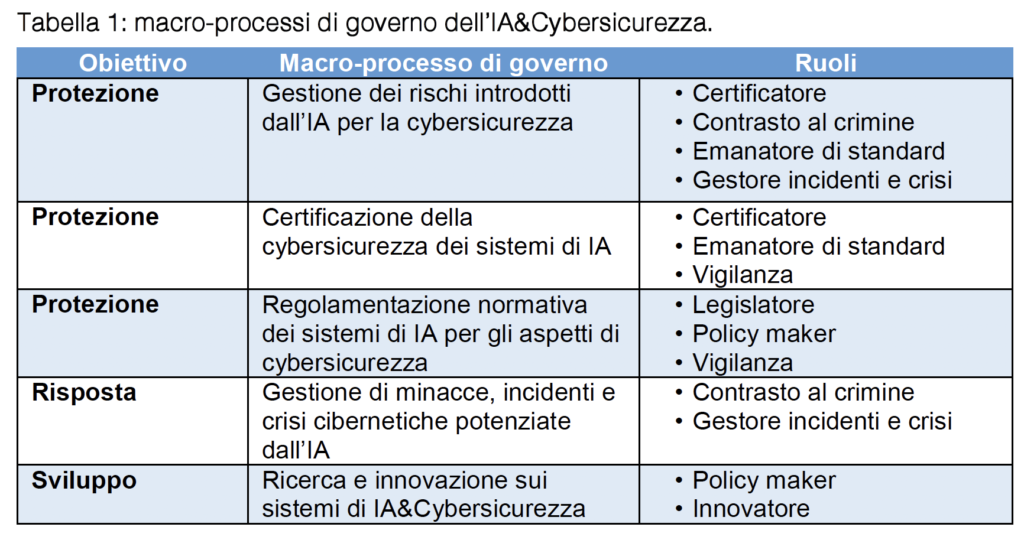

Macro-processi di governo dell’IA&Cybersicurezza

In qualità di Autorità nazionale per la cybersicurezza a tutela degli interessi nazionali nello spazio cibernetico, secondo il D.L. 82/2021 [10], l’ACN ha il compito di garantire la sicurezza e la resilienza nello spazio cibernetico, occupandosi di prevenire e mitigare il maggior numero di attacchi cibernetici e di favorire il raggiungimento dell’autonomia tecnologica. Come illustrato in Figura 2, a tal fine collabora con i soggetti dell’architettura nazionale di cybersicurezza che includono le Forze di Polizia, il Ministero della Difesa e il comparto intelligence.

L’IA rappresenta senza dubbio una tecnologia di cruciale importanza per la resilienza cibernetica del Paese, tuttavia, la strategia adottata da questa nel prendere decisioni, specialmente nel caso dei recenti modelli generativi del linguaggio, non è facilmente controllabile e potenzialmente dipende dallo scenario in cui l’IA è adottata, determinando potenziali rischi di sicurezza con possibili ripercussioni anche sull’incolumità fisica delle persone.

Pertanto, risulta di estrema importanza individuare un insieme di macro-processi di governo dell’IA&Cybersicurezza. Tali macro-processi sono riportati in Tabella 1 e descritti nel seguito raggruppati per i tre obiettivi di protezione, risposta e sviluppo della Strategia [9].

Gestione dei rischi introdotti dall’IA per la cybersicurezza

Come cambia lo scenario delle minacce per i sistemi basati su IA

L’analisi dei rischi di sicurezza cui sono esposti i sistemi parte tipicamente dall’identificazione dei loro componenti principali, e per ognuno di essi, delle proprietà di sicurezza che è necessario preservare, in modo da evitarne la compromissione a fronte di potenziali eventi dannosi.

Per quanto riguarda il governo dei rischi nel contesto specifico dei sistemi di IA, per la loro specifica natura e in ragione delle specifiche implicazioni etiche e impatti sulla società, il confine tra sicurezza e affidabilità (trustworthiness) è molto sottile, in quanto tipicamente quest’ultima garantisce che il comportamento dei tali sistemi possa essere controllato (audited) e verificato (verified) [5].

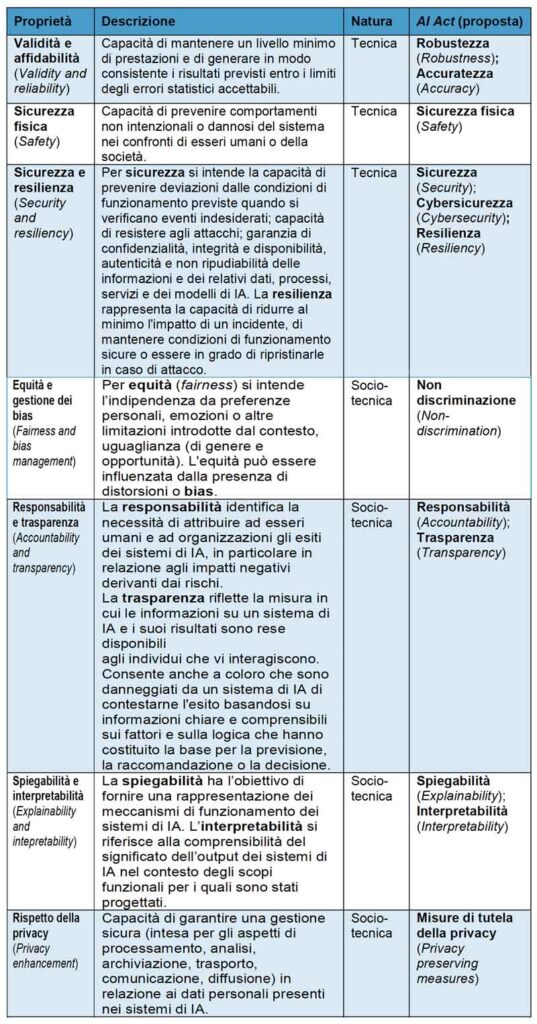

In Tabella 2 è riportato un elenco di proprietà che in base a quanto identificato nell’Artificial Intelligence Risk Management Framework (AI RMF) sviluppato dal National Institute of Standards and Technology (NIST) statunitense sono ritenute fondamentali nel progetto di sistemi di IA affidabili [11]. Tali proprietà, anche in relazione ai risvolti etici e sociali suesposti dei sistemi di IA, non sono solamente di natura puramente tecnica, ma anche socio-tecnica. La tabella mostra anche la relazione tra tali proprietà e i concetti espressi nell’AI Act [12].

Nel processo di analisi, valutazione e mitigazione dei rischi è importante adottare pertanto un approccio globale, che permetta di individuare eventuali compromessi tra proprietà tecniche e socio-tecniche per raggiungere un elevato grado di controllo del rischio pur mantenendo alto livello di qualità delle prestazioni. È opportuno sottolineare che tali proprietà sono infatti fortemente accoppiate, nel senso che vanno garantite in modo simultaneo: sistemi altamente sicuri ma iniqui, sistemi accurati ma opachi e non interpretabili, e sistemi imprecisi ma equi, sicuri e trasparenti sono tutti indesiderabili [11].

Nel seguito, ci concentreremo sulle caratteristiche tecniche e in particolare sulla proprietà di sicurezza e resilienza, con particolare riferimento alla sicurezza delle informazioni quali riservatezza (confidentiality), integrità (integrity) e disponibilità (availability) esaminandone le principali minacce che attengono allo specifico contesto dell’IA5.

Nella prossima sezione illustreremo le minacce cyber ai modelli di machine learning, considerati i principali protagonisti di questa rivoluzione, presenti all’interno di una vastissima gamma di prodotti che permeano la nostra vita quotidiana. Questi modelli imparano ad associare ad un input un dato output sulla base di quanto appreso da un set di dati.

Principali attacchi cyber ai sistemi di IA

I principali elementi dei sistemi di IA oggetto di attacco sono il modello di IA e i dati utilizzati per il suo addestramento. Nel seguito esamineremo nel dettaglio i principali attacchi alla confidenzialità e all’integrità di questi.

Attacchi alla confidenzialità. Questo tipo di attacchi ha generalmente lo scopo di dedurre informazioni sensibili su modello o sui dati di addestramento. Esempi includono:

• attacchi di appartenenza (membership). Tentano di determinare se un particolare dato (ad esempio appartenente ad una persona specifica) è stato utilizzato per addestrare uno specifico modello di IA, consentendo ad un attaccante di dedurre informazioni sensibili sui dati di addestramento e mettendo pertanto a rischio la privacy degli utenti;

• estrazione e inversione del modello (model extraction and inversion). Si concentrano sull’estrazione o il recupero del modello di IA stesso. Tali attacchi possono essere perpetrati direttamente (estrazione) o indirettamente (inversione, cioè tramite tecniche c.d. di reverse engineering), ovvero cercando di ottenere informazioni sul modello addestrato (quali ad esempio la sua architettura), ad esempio mediante l’analisi delle risposte del modello alle richieste di input. Tra le tipologie di attaccanti figurano tipicamente i concorrenti sleali sul mercato.

Attacchi all’integrità. Questo tipo di attacchi hanno lo scopo di ingannare o eludere il funzionamento dei sistemi di IA durante la fase di addestramento o di inferenza al fine di influenzarne le previsioni o indurre comportamenti non desiderati o addirittura pericolosi quando il modello viene utilizzato in produzione, come ad esempio far riconoscere come sicuri oggetti pericolosi o far rifiutare oggetti innocui.

Questi possono essere suddivisi nelle due seguenti principali categorie:

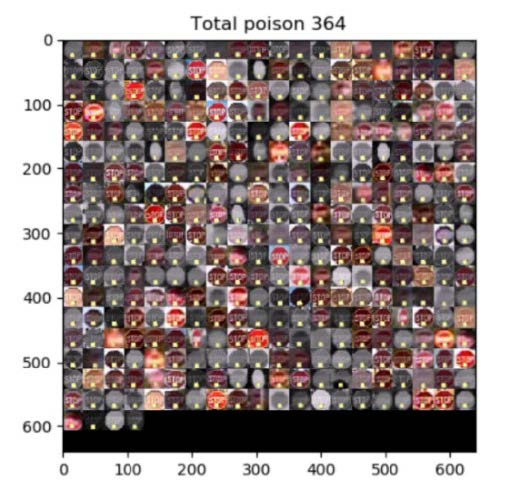

• attacchi ad “avvelenamento” (poisoning). Gli attacchi all’avvelenamento dei dati (data poisoning) consistono nell’immettere dati malevoli o manipolati nel set di addestramento di un modello di IA per introdurre bias (ovvero, capacità discriminative indesiderate) o influenzarne le decisioni. Una sottocategoria di questi attacchi (detti a “backdoor”) sfrutta l’inserimento malizioso di dati nel set di addestramento, che però contengono al loro interno delle specifiche “esche” (trigger), ovvero porzioni di dati che il modello, a valle dell’addestramento, impara a riconoscere e associare ad un determinato output deciso dall’attaccante. Si noti che rispetto al caso generale, questa particolare sottocategoria fornisce all’attaccante la “chiave” per determinare una specifica decisione, mostrando dati che contengono “l’esca” al modello. L’esempio in Figura 3 mostra l’utilizzo di un trigger nel dominio del riconoscimento di immagini, in cui i trigger hanno la forma di piccole trame (pattern) o proiezioni difficili da vedere: nello specifico, un semplice post-it posizionato sui segnali stradali può influenzare un sistema di riconoscimento dei segnali a riconoscere un segnale di “stop” come un segnale di limite di velocità, portando un eventuale veicolo a guida autonoma con a bordo tale sistema di riconoscimento a non rispettare lo “stop” ed eventualmente mettere a repentaglio la sicurezza fisica dei pedoni. Recenti studi dimostrano la fattibilità di attacchi di data poisoning a dataset di grandi dimensioni, come ad esempio Wikipedia, che possono essere utilizzati per il training di LLM [14].

Altri attacchi tentano di “avvelenare” direttamente il modello (model poisoning) a valle dell’addestramento per inserire funzionalità dannose [15];

• Attacchi a elusione (evasion). Contrariamente alla precedente, questa categoria non mira a compromettere l’integrità del modello o dei dati di addestramento, ma, piuttosto, del processo di inferenza. Questi attacchi, infatti, sfruttano le vulnerabilità dei modelli di IA ai cosiddetti esempi “avversari” (adversarial examples), ovvero input appositamente progettati per ingannare il modello e indurlo a commettere errori.

(a) Il modello di riconoscimento di segnali stradali in [16], addestrato su un set di addestramento “avvelenato”, ha riconosciuto il cartello in figura come segnale di “limite di velocità” invece che di “stop”, a causa del bigliettino posizionato nella parte sottostante. Il numero visualizzato mostra la confidenza del modello nella specifica (errata) classificazione (probabilità prossima ad 1).

(b) L’insieme delle backdoor (segnali di “stop” modificati e contenenti quadratini gialli nella porzione bassa dell’immagine) inseriti nel set di addestramento del modello di cui alla Figura 3a e categorizzati come “limiti di velocità”. Immagine tratta da [17].

Figura 3 Esempio di uso di un trigger per alterare la decisione di un modello di IA.

Attacchi alla disponibilità. In questo tipo di attacchi l’attaccante tenta di deteriorare le prestazioni del sistema di IA. Alcune delle tipologie di attacchi menzionate nelle precedenti categorie relative a confidenzialità e integrità possono essere istanziate anche allo scopo di ridurre l’accuratezza del sistema (di fatto, controllando una frazione del set di addestramento del modello mediante data poisoning, riducendo l’efficacia del processo di apprendimento o, alterando in modo artificioso i parametri del modello mediante model poisoning) [18]. Alcuni studi dimostrano inoltre la fattibilità di attacchi basati sulla creazione di input ad arte per massimizzare il consumo di energia e la latenza dei modelli, causando un degrado di prestazioni [19].

Gli attacchi su menzionati sono applicabili ad ampio spettro sulla tassonomia generale dei sistemi di IA, tuttavia, alcuni sistemi di IA basati sui modelli generativi sono particolare soggetti a possibili manipolazioni dei cosiddetti prompt, ovvero specifiche (tipicamente testuali e a cura dell’utente stesso, o di un fornitore del servizio) del compito che il sistema deve compiere e di come il sistema stesso deve gestire l’interazione con l’utente. Questo può comportare la compromissione di tutte le citate proprietà di sicurezza [18]. In particolare, ad esempio, tali prompt possono essere alterati da parte di attaccanti (prompt injection), allo scopo di manipolare il comportamento del sistema, inserendo istruzioni dannose o ambigue, oppure estratti (prompt extraction) allo scopo di derivare informazioni sul funzionamento del sistema.

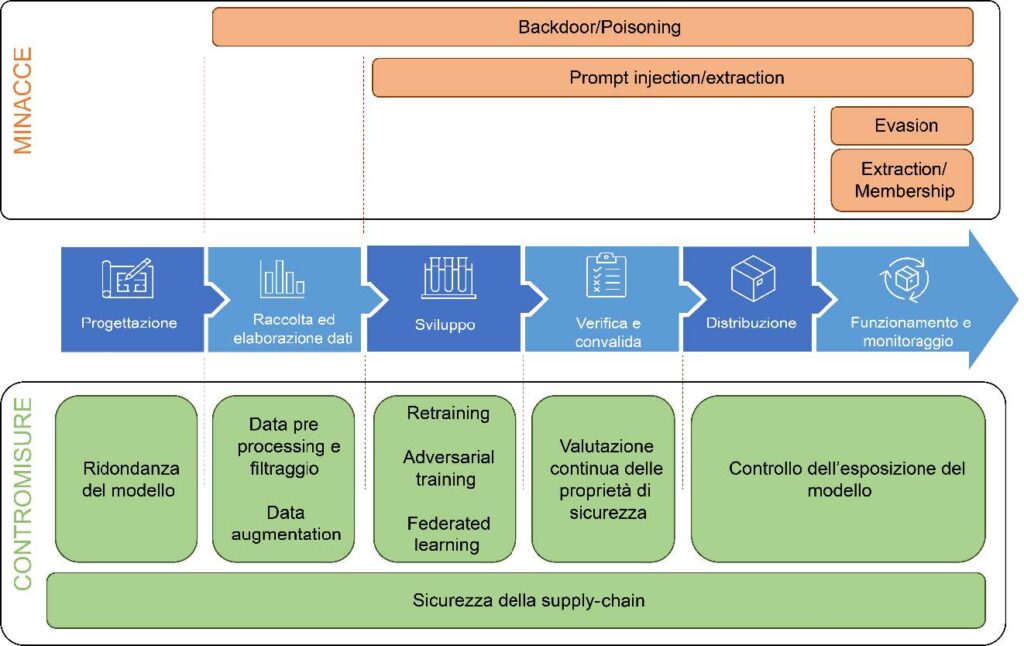

Per mitigare i rischi di questo tipo di attacchi, è necessario stabilire processi e procedure di security-by-design in ogni fase dello sviluppo dei sistemi, dalla scelta dell’architettura dei modelli, alla progettazione delle procedure di apprendimento, all’implementazione e al test e in particolare nella fase di messa in opera finale del sistema.

Figura 4 Corrispondenza tra le fasi del ciclo di vita dei sistemi di IA, minacce e contromisure [20] [11].

In Figura 4 è rappresentata una schematizzazione (in blu), secondo la definizione dell’Organizzazione per la Cooperazione e lo Sviluppo Economico (OCSE) [20], delle principali fasi del ciclo di vita di un sistema di IA: 1) progettazione, 2) raccolta ed elaborazione dei dati, 3) sviluppo del modello, 4) verifica e convalida, 5) distribuzione (deployment); 6) funzionamento e monitoraggio. In relazione alle fasi, è possibile ricondurre il processo di apprendimento alla fase 2) per il suo progetto e alla fase 3) per l’apprendimento effettivo; il processo di inferenza avviene invece nella fase finale (fase 6). Per ogni fase la figura evidenzia (in rosso) le minacce precedentemente identificate e (in verde) un elenco sintetico delle principali contromisure di natura tecnica e organizzativa per la mitigazione dei relativi impatti di sicurezza. Queste ultime sono in particolare approfondite nella prossima sezione.

Contromisure per i rischi cyber specifici dell’IA

Gli attacchi alla confidenzialità dei dati di apprendimento dei modelli possono essere mitigati tramite tecniche quali l’apprendimento federato (federated-learning), ovvero tecniche in cui il processo di apprendimento è effettuato in modo decentralizzato riducendo al minimo l’impatto di eventuali violazioni di dati (data breach). Inoltre, ridurre la tipologia e il numero di informazioni [21] che vengono fornite nella produzione degli output del modello di IA può aiutare a incrementare lo sforzo necessario per un attaccante a perpetrare tali attacchi.

In relazione agli attacchi all’integrità tramite avvelenamento, l’insieme di dati di addestramento dovrebbe essere ampliato il più possibile tramite metodologie apposite (c.d. di data augmentation6 [21]) per ridurne la suscettibilità all’inserimento di dati manipolati (di fatto, irrobustendo il modello sfruttando un effetto di “diluizione”). Similmente, approcci di riapprendimento (retraining) reiterati nel tempo con dati di addestramento benigni riducono la probabilità dell’efficacia delle backdoor [22] [23]. Questi approcci possono essere rafforzati da strategie di pre-elaborazione (pre-processing) che tentano di ripulire i dati di addestramento dai dati avvelenati7 (in particolare quest’ultima strategia è l’unica efficace per mitigare gli attacchi di tipo backdoor [24] [23]).

Per contrastare gli attacchi all’integrità di tipo elusione, è possibile implementare strumenti per rilevare se un dato input è un esempio avversario. Inoltre, l’addestramento avversario (adversarial training), consiste nel generare in modo iterativo esempi contraddittori inserendoli nel set di addestramento e addestrare ripetutamente il modello su di essi, con l’obiettivo di aumentarne la robustezza e significativamente ridurre la capacità di un dato aggressore di studiare correttamente il modello sottostante e creare esempi avversari efficaci.

In aggiunta a quanto descritto, vi sono una serie di ulteriori contromisure utili per ridurre ulteriormente la superficie di attacco dei sistemi di IA:

• controllo dell’esposizione esterna dei modello. Devono essere implementati processi che minimizzano l’esposizione all’esterno delle caratteristiche interne del modello di IA, in quanto queste possono permettere all’attaccante di realizzare attacchi più efficaci. In particolare, nel caso del riconoscimento di immagini, con informazioni puntuali sul modello8, l’attaccante può essere in grado di conoscere la migliore perturbazione da aggiungere ad un’immagine per indurre uno specifico errore di decisione;

• ridondanza del modello. In fase di progetto, la ridondanza implica la creazione di più modelli che presentano variazioni nei loro approcci o dati di addestramento e che vengono combinati insieme (model ensemble o bagging) per prendere decisioni9. Questa combinazione riduce la dipendenza da un singolo modello, per cui un eventuale attacco diventa meno efficace poiché gli altri modelli possono essere utilizzati per rilevare e mitigare il problema;

• valutazione continua delle proprietà di sicurezza. Essendo l’IA in continua evoluzione è necessario istruire processi che mantengono i livelli di sicurezza dei componenti nel tempo. Il controllo regolare della presenza di nuovi attacchi e difese deve essere integrato nei processi, e in generale, per via del mutamento continuo di questi sistemi e per via del loro apprendimento continuo dai dati, è opportuno identificare e valutare controlli di sicurezza che possano applicarsi in modo continuo;

• sicurezza della supply chain e controllo nel riuso di modelli e dati. È prassi comune basare il progetto di sistemi di IA su modelli di IA progettati o addestrati da terze parti10 e resi disponibili pubblicamente11. Per addestrare il modello, è spesso necessario che il fornitore acceda ai dati. Ciò comporta la condivisione dei dati potenzialmente sensibili con una terza parte. In questi scenari, attori malevoli potrebbero essere in grado di alterare il comportamento del modello, manipolandolo o manipolando i dati utilizzati per addestrarlo. In generale, a seconda dei requisiti di sicurezza per il caso d’uso, è essenziale compiere sforzi adeguati a garantire che la catena di approvvigionamento [25] e le fonti dei dati di addestramento, dei modelli e degli algoritmi di addestramento siano note e affidabili.

In definitiva, garantire il rispetto dell’affidabilità e la sicurezza di questi sistemi, e quindi lo sviluppo di framework per la loro certificazione e valutazione (oggetto di trattazione nella Sezione 3.2) è particolarmente complesso. Evidenziamo come le capacità di apprendimento automatico sono un ulteriore fattore di difficoltà poiché queste determinano una sistemica evoluzione temporale, la cui principale conseguenza è il fatto che le proprietà di sicurezza possono degradarsi e che non tutti i risultati attesi sono noti a priori.

Certificazione della cybersicurezza dei sistemi di IA

Il mandato del macro-processo di certificazione della cybersicurezza dei sistemi di IA è da ricondursi alla legislazione vigente (si veda in proposito la Sezione 3.3), alquanto articolata nell’impianto dato dall’UE e in evoluzione al momento in cui scriviamo. Nell’ottica di massimizzare efficacia ed efficienza di un nuovo schema di certificazione in materia di IA, l’ENISA ne sta studiando gli obiettivi e le potenziali sinergie con altri schemi di certificazione in corso di definizione12 e, al tempo stesso, raccomanda agli Stati Membri di prestare attenzione all’armonizzazione delle competenze tra gli attori governativi nella fase di recepimento a livello nazionale dei regolamenti comunitari da parte del legislatore [26].

Il macro-processo di certificazione contribuisce all’obiettivo di protezione tramite accurate verifiche del livello di conformità di un prodotto basato sull’IA rispetto ai vincoli imposti dal legislatore e alle norme tecniche stabilite dagli enti di normazione. Similmente a quanto già accade con altri prodotti di ICT non basati su IA13, le aziende sottoporranno i propri prodotti che integrano sistemi di IA ad un audit condotto da parte di attori governativi, amministrazioni pubbliche o aziende private precedentemente accreditate dalle autorità (quali, ad esempio, laboratori di prova o valutazione14. Tale audit è finalizzato al rilascio di un certificato di conformità, un “bollino di qualità” del prodotto, la cui validità è limitata nel tempo o dalla legge stessa o in conseguenza di sostanziali modifiche ed evoluzioni del prodotto. Lo scopo finale di questo macro-processo è la protezione degli asset, ma anche quello di ingenerare fiducia (trust) nelle persone e nelle aziende che andranno ad utilizzare prodotti e sistemi basati su IA: mentre i primi mirano alla tutela dei propri diritti fondamentali digitali, le seconde sono interessate alla sicurezza dei prodotti e della propria catena di approvvigionamento (supply chain)15 [25].

Il “mezzo” tramite il quale i requisiti legislativi sono codificati in specifiche tecniche fondamentali per guidare lo sviluppo di sistemi e prodotti di IA da parte delle aziende sono le norme tecniche, in inglese standard, emanati dagli enti di normazione. In vari domini, gli standard documentano le caratteristiche che i prodotti devono possedere al fine di promuoverne l’interoperabilità e migliorarne la sicurezza, abilitando economie di scala e incoraggiando la concorrenza. Nel caso specifico dell’IA, oltre agli standard tradizionali ereditati dal dominio della cybersicurezza16, è necessario sviluppare norme tecniche ad hoc per i prodotti basati sull’IA in base ai requisiti imposti dalla legge. Al momento, i principali enti di normazione impegnati nel campo dell’IA&Cybersicurezza sono i seguenti [13] [26]:

• a livello internazionale globale, l’International Organization for Standardization (ISO) e l’International Electrotechnical Commission (IEC). I due enti stanno attivamente collaborando in un Joint Technical Committee (JTC) 1/Subcommittee (SP) 4217 dedicato all’IA in cui vengono prodotte norme tecniche generali18, da verticalizzare in altri comitati;

• a livello continentale europeo, il Comitato Europeo di Normazione (CEN) e il Comitato Europeo di Normazione Elettrotecnica (CENELEC), i quali stanno trattando congiuntamente il tema dell’IA nella JTC 21. In particolare, tale comitato si occupa anzitutto di identificare e adottare standard internazionali già pubblicati, come quelli al punto precedente, quindi di sviluppare norme tecniche specifiche per la società e il mercato europei secondo le richieste del legislatore (ad esempio, in merito all’attuazione dell’AI Act – si veda la Sezione 3.3).

Tra le associazioni di standardizzazione, invece, segnaliamo la Technical Committee (TC) denominata “Securing Artificial Intelligence” (SAI) dell’Istituto Europeo per le norme di Telecomunicazioni (European Telecommunications Standards Institute, ETSI). Il comitato si concentra su tutte e tre le direzioni della relazione tra IA e cybersicurezza che abbiamo menzionato all’inizio di Sezione 2, ovvero la messa in sicurezza dell’IA, l’utilizzo dell’IA per scopi di difesa e la mitigazione di attacchi effettuati da counter-AI.

A proposito di tali iniziative di standardizzazione, però, è interessante notare come i rapidissimi cicli di innovazione in materia di IA e il quadro legislativo in continua evoluzione non si adattino alle tempistiche, tradizionalmente medio-lunghe sulla base del meccanismo del consenso, della redazione di una norma tecnica19. Inoltre, le norme tecniche, in un momento di grande spunto per l’impresa, non devono essere eccessivamente prescrittive, andando a cercare piuttosto sinergie con le aziende e i legislatori stessi basato su sforzi di ricerca, innovazione e sviluppo con i quali rendere lo standard “usabile”, ovvero implementabile in pratica e aggiornato dal punto di vista tecnologico. In definitiva, secondo l’ENISA stessa [13], sono necessari ulteriori sforzi di ricerca per valutare la sicurezza dei sistemi di IA, al fine di definire delle metodologie condivise ed oggettive da riportare negli standard.

Regolamentazione normativa dei sistemi di IA per gli aspetti di cybersicurezza

Dal punto di vista normativo, l’UE sta portando avanti tre principali iniziative inerenti l’IA e la cybersicurezza che, una volta approvate, dovranno essere recepite a livello dei singoli Stati Membri.

• Anzitutto, sta giungendo all’approvazione finale l’AI Act20, un articolato regolamento comunitario21 finalizzato a normare l’immissione sul mercato di prodotti basati su IA per mezzo di una classificazione basata sul rischio di creare danno agli esseri umani. In particolare, tale classificazione identifica una categoria di utilizzi dell’IA a rischio inaccettabile (e pertanto vietati), e una categoria di sistemi ad alto rischio, prescrivendo, per i produttori e gli utilizzatori di questi, alcuni requisiti generali di conformità, che includono aspetti di gestione del rischio, accuratezza, robustezza e cybersicurezza. Nell’ottica dell’attuazione del regolamento, la Commissione Europea ha effettuato richieste di normazione tecnica (standardization request – SR) [27] a CEN-CENELEC22 per colmare il gap esistente nel panorama della standardizzazione internazionale – come visto nella Sezione

• Inoltre, per quanto attiene gli specifici aspetti di cybersicurezza, il Cyber Resilience Act23 (CRA), che adotta un’impostazione basata sul rischio come l’AI Act, stabilirà requisiti e metodologie orizzontali di garanzia della cybersicurezza per produttori e fornitori di prodotti digitali e di servizi accessori inclusi quelli basati su IA. Un elemento chiave della proposta è la copertura dell’intero ciclo di vita dei prodotti, con la specifica istituzione di obblighi per produttori e sviluppatori al fine di definire un periodo di supporto, durante il quale verranno forniti obbligatoriamente tutti gli aggiornamenti di sicurezza. Tali obblighi saranno stabiliti per gli operatori economici (produttori, distributori e importatori) in relazione all’introduzione sul mercato di prodotti con elementi digitali, sulla base delle specifiche responsabilità nella catena di approvvigionamento.

• Parallelamente ai precedenti, lo European Chips Act24 mira a definire requisiti di cybersicurezza by-design per la progettazione di circuiti basati su semiconduttori, fondamentali per l’IA sia per quanto riguarda le architetture di calcolo (ad esempio, le infrastrutture di calcolo ad elevate prestazioni – high performance computing, HPC – utilizzate per l’addestramento dei modelli di machine learning più complessi), sia per quanto riguarda i sistemi integrati (embedded), che hanno a bordo modelli di inferenza basati su IA (ad esempio, alcuni chip per il riconoscimento biometrico che rientrano nelle previsioni dei sistemi ad alto rischio individuati dall’AI Act).

Globalmente è possibile osservare tre principali approcci esistenti, alla data di scrittura del presente articolo, alla regolazione dell’IA. Se da un lato l’UE, come sopra riportato, ha elaborato proposte specifiche che riflettono una visione precauzionale e orientata ai diritti degli utilizzatori, l’approccio anglosassone (USA e Regno Unito) si distingue per un orientamento che, pur contemperando le preoccupazioni etiche e di sicurezza, eviti vincoli eccessivi che potrebbero ostacolare la crescita dell’economia digitale e l’innovazione tecnologica, anche attraverso l’incoraggiamento della collaborazione pubblico-privata per lo sviluppo di norme e linee guida che forniscano un quadro chiaro in cui l’industria può operare25. La Cina ha destinato considerevoli risorse e investimenti nella direzione di diventare leader mondiale nell’IA, ponendo tuttavia, anche in ragione delle specificità politiche, culturali ed economiche, particolare enfasi sulla garanzia che la tecnologia sia allineata con gli obiettivi strategici del paese [28], anche per le finalità di sicurezza nazionale, con un approccio più mirato alla normazione tecnica di tipologie specifiche di IA, come i sistemi di raccomandazione e, più recentemente, per gli algoritmi generativi [29].

Nel mondo e anche in Italia, le grandi aziende tecnologiche manifestano in sempre più occasioni l’intenzione di unire gli sforzi per promuovere proattivamente lo sviluppo responsabile di modelli, sistemi e prodotti di IA, minimizzando i rischi e condividendo informazioni con la società civile e i policy maker26. In quest’ottica, l’attenzione degli attori governativi italiani è alta nel tentativo di ridurre le barriere allo sviluppo e al raggiungimento di una autonomia tecnologica, anche attraverso il confronto con le aziende nel processo di attuazione della regolamentazione normativa. Un primo esempio di tali sinergie è costituito dalla stesura delle linee guida per lo sviluppo sicuro dell’IA [30], promosse dal National Cyber Security Centre (NCSC) del Regno Unito e dalla Cybersecurity and Infrastructure Agency (CISA) degli USA e cui hanno aderito 23 Agenzie di 18 Paesi, tra cui l’ACN italiana, e realizzate anche grazie al contributo di diversi soggetti privati.

Gestione di minacce, incidenti e crisi cibernetiche potenziate dall’IA

Come evidenziato in [31], i recenti sviluppi dell’IA, in particolare sul fronte dell’IA generativa, hanno portato ad un fondamentale cambio di paradigma nelle metodologie necessarie ad assicurare la sicurezza cibernetica. In particolare, tale cambio si sostanzia in alcuni elementi specifici che includono:

• diminuzione dell’efficacia degli aggiornamenti del software, che, con il paradigma tradizionale, sono invece tra le principali misure di difesa da attacchi cyber. Infatti, la velocità con cui attacchi basati su IA possono essere realizzati e condotti si scontra con la lentezza che invece attualmente caratterizza le strategie di aggiornamento dei sistemi, determinando una sproporzione in favore degli attacchi;

• necessità di meccanismi di risposta con gradi di automazione maggiore, determinata anch’essa dalla velocità delle nuove tipologie di attacco basate su IA, oltre che dalla elevata scala che tali attacchi possono assumere;

• maggiore vulnerabilità degli esseri umani, che possono essere oggetto di attacchi più sofisticati e mirati a causa dell’impiego di sistemi di IA generativa. Si pensi ad esempio ad e-mail di phishing personalizzate o a messaggi vocali manipolati che riescano a riprodurre fedelmente le voci di amici o colleghi;

• sovranità digitale, ed in particolare la dipendenza dell’UE da modelli di IA generativa sviluppati al di fuori dell’Europa, e con principi etici che possono essere fondamentalmente diversi, così determinando problemi di allineamento culturale.

Pertanto, si rende necessario ridefinire i processi di gestione delle minacce, degli incidenti e delle crisi cibernetiche potenziate dall’IA di modo da includere nuovi insiemi di misure da attuare per proteggersi dalla minaccia, e nuovi processi che ridefiniscano i comportamenti che gli esseri umani devono tenere in scenari di difesa in cui è enormemente cresciuta la complessità delle interazioni tra agenti umani e artificiali.

Ricerca e innovazione sui sistemi di IA&Cybersicurezza

L’ultimo macro-processo si occupa di gestire le molteplici sfide poste dalle varie connotazioni di IA&Cybersicurezza, oltre che dagli altri macro-processi precedentemente descritti, e che attualmente sono ancora sulla frontiera di ricerca.

A livello europeo, l’ENISA ha pubblicato diversi studi e documenti di indirizzo su temi di cybersicurezza e IA. In particolare, [32] è stato recepito come indirizzo per l’Agenda di Ricerca e Innovazione di ACN. Più recentemente, [5] individua alcuni gap di ricerca e innovazione in IA&Cybersicurezza, che includono:

• necessità di testbed, per studiare e ottimizzare metodi e tecnologie;

• sviluppo di strumenti di penetration test basati su IA e machine learning per trovare vulnerabilità e valutare il comportamento degli attaccanti;

• sviluppo di framework standard;

• sviluppo di modelli di training per professionisti che utilizzino scenari realistici;

• istituzione di un osservatorio per l’intelligenza artificiale e le minacce alla cybersicurezza.

Dal punto di vista dei finanziamenti sui temi relativi all’IA&Cybersicurezza possiamo citare i programmi Horizon Europe (in particolare, il Cluster 3 – “Civil Security for Society”, con 1,6 miliardi di euro) e Digital Europe, quest’ultimo con 1,6 miliardi di euro destinati alla cybersecurity e 2 miliardi di euro a Cloud, Data e IA.

A livello nazionale, sono stati già avviati importanti programmi di finanziamento che hanno dato luogo a numerosi investimenti in corso, tra cui citiamo i finanziamenti del Piano Nazionale di Ripresa e Resilienza (PNRR) per la costituzione dei partenariati estesi SERICS – “SEcurity and RIghts in CyberSpace” e FAIR – “Future Artificial Intelligence Research”.

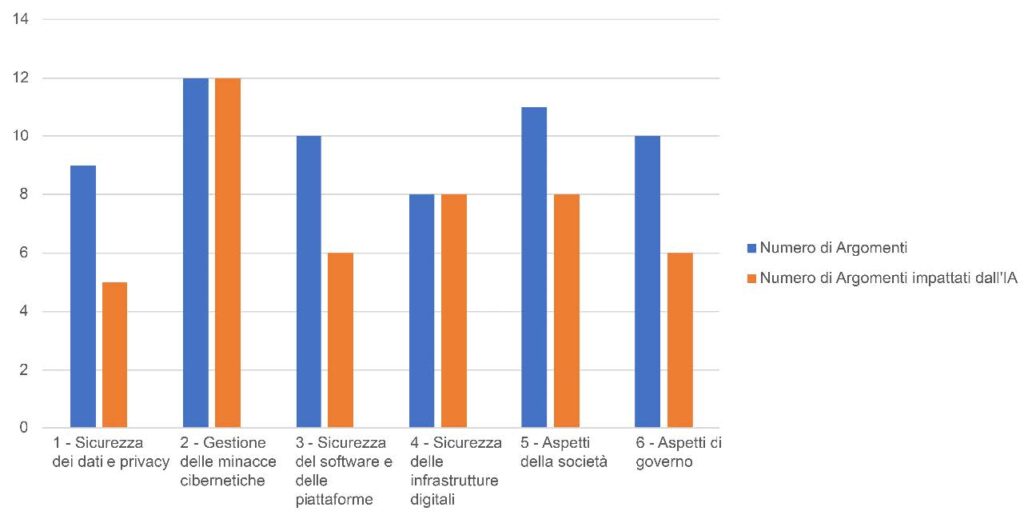

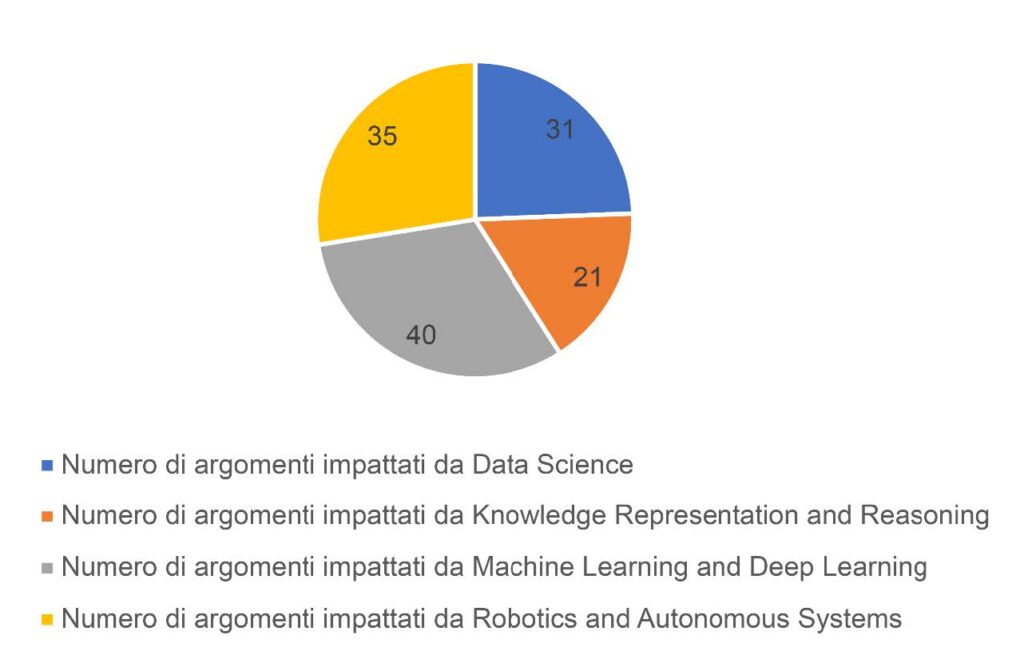

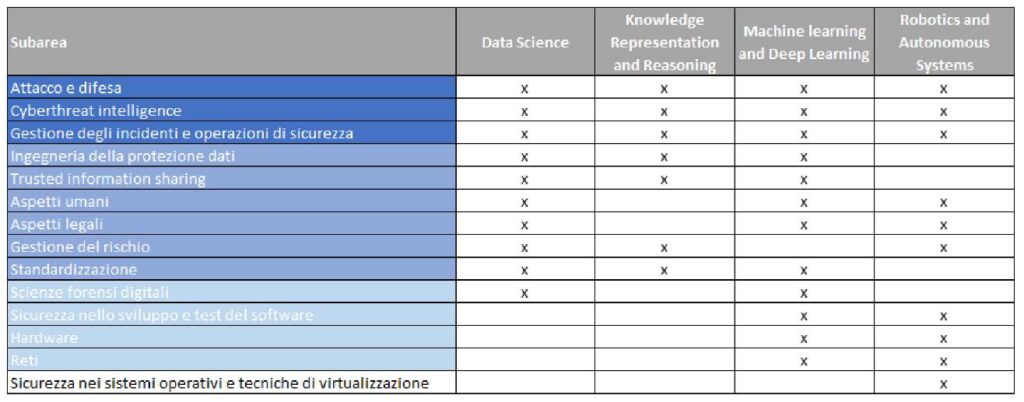

L’ACN, in collaborazione con il Ministero dell’Università e della Ricerca, ha pubblicato un’Agenda di Ricerca e Innovazione per la Cybersicurezza [7] basata su rilevanti riferimenti sia nazionali che internazionali, al fine di promuovere e valorizzare i prodotti di ricerca di cybersicurezza sia in ambito pubblico sia in quello privato. L’Agenda identifica 6 aree nel dominio di conoscenza della cybersicurezza, 18 subaree e 60 argomenti di ricerca prioritari afferenti alle diverse subaree. Individua inoltre un insieme di Emerging and Disruptive Technology (EDT) che supportano o vincolano gli argomenti di ricerca dell’Agenda.

L’IA è identificabile come una combinazione di quattro di esse: data science, rappresentazione della conoscenza (knowledge representation and reasoning), machine learning e deep learning, robotica e sistemi autonomi (robotics and autonomous systems) [7].

Come riportato in Figura 5, l’IA in generale ha un forte impatto su tutte le aree individuate dall’Agenda (vedasi grafico in Figura 5a). Inoltre, andando a considerare le singole EDT costituenti l’IA, si può apprezzare come il contributo allo studio degli argomenti prioritari dell’Agenda è sostanzialmente equidistribuito tra di esse, con una lieve predominanza dell’EDT machine learning and deep learning. Possiamo, quindi, affermare che ciascuna EDT ha un impatto rilevante sulla ricerca e l’innovazione per la cybersicurezza (vedasi grafico in Figura 5b).

(a) Impatto dell’IA sulle diverse aree di ricerca e innovazione individuate dall’Agenda

(b) Contributo delle singole EDT costituenti l’IA allo studio degli argomenti dell’Agenda

Figura 5 Relazioni tra l’IA e gli argomenti di ricerca dell’Agenda

Focalizzandosi, invece, sulle subaree individuate dall’Agenda, ben 14 su 18 di esse sono direttamente impattate da almeno una delle quattro EDT costituenti l’IA. In particolare, dalla Figura 6 è possibile apprezzare le 14 subaree in ordine di impatto decrescente, sulla base di quante EDT sono state associate a ciascuna di esse nell’Agenda (vedasi Tabella 3-3 in [7]).

Figura 6 Relazione tra le EDT che costituiscono l’IA e le subaree impattate.

Nell’ottica delle tre declinazioni della relazione tra cybersicurezza e IA (vedasi inizio di Sezione 2), osserviamo infine che:

• l’Argomento #2.1.3 – “Messa in sicurezza di algoritmi e modelli di machine learning” è totalmente dedicato agli aspetti di cybersicurezza dell’IA;

• l’IA per la cybersicurezza e l’IA per scopi offensivi sono rilevanti, in particolare, per l’Area #2 – “Gestione delle minacce cibernetiche” che, infatti, è interessata da tali tecniche per il tramite di tutte le subaree ad essa afferenti (#2.1 – “Attacco e difesa”, #2.2 – “Cyberthreat intelligence”, #2.3 – “Gestione degli incidenti e operazioni di sicurezza” e #2.4 – “Scienze forensi digitali”).

I filoni principali di finanziamento che anche l’ACN supporterà a livello nazionale italiano includono [9]:

• ricerca e innovazione in ambito IA&Cybersicurezza, con riferimento sia a dottorati di ricerca sia alla crescita delle imprese e all’efficienza ed efficacia dei servizi di difesa cyber nazionale;

• promozione di attività di test e sperimentazione per valutare soluzioni di IA, ed in particolare sandbox, cyber range, ambienti di test per soluzioni di IA cybersicure e per IA a supporto della difesa da minacce cibernetiche.

Applicazioni di IA&Cybersicurezza

In questa sezione analizzeremo tre applicazioni esemplificative, ma rappresentative, di IA&Cybersicurezza. Nello specifico, le prime due applicazioni sono esempi di IA a supporto della cybersicurezza, mentre il terzo è di IA per scopi offensivi (cfr. Sezione 2).

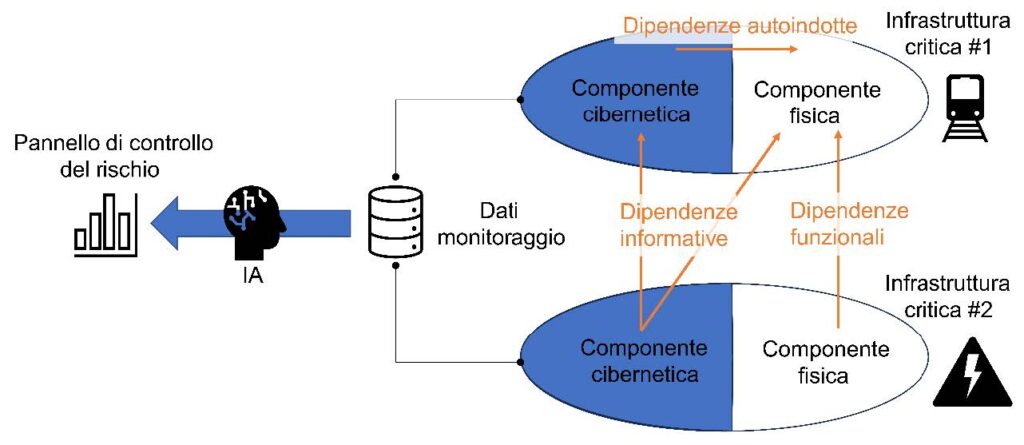

Caso d’uso: IA nella cybersicurezza delle infrastrutture critiche

Le infrastrutture critiche costituiscono sistemi complessi essenziali per il mantenimento delle funzioni vitali della società, dalla salute al benessere economico delle persone, e sono tali che un’interruzione dei servizi da loro offerti comporterebbe un significativo impatto per lo Stato. Per questo motivo, è necessario proteggerle sia dalle minacce provenienti dal mondo fisico, siano esse riconducibili a disastri naturali imprevedibili oppure ad attacchi cinetici dolosi, che dal cyberspazio. Tali minacce possono essere dirette alla singola infrastruttura critica, ma possono anche derivare dalle catene di approvvigionamento [25] dei servizi offerti da un’infrastruttura critica all’altra, determinando diverse dipendenze come raffigurato in Figura 7.

In letteratura esistono metodologie analitiche e strumenti di valutazione e monitoraggio del rischio cibernetico27, ma considerata la grande mole di dati che si può ottenere dal monitoraggio automatizzato dei sistemi informatici e di rete, potrebbe essere strategico implementare un sistema di IA in grado di aumentare le capacità di prevenzione degli incidenti. Tale sistema dovrebbe effettuare operazioni di data preparation sulla grande mole di dati raccolta, implementare algoritmi di machine learning per effettuare inferenza, predizioni, simulazioni di comportamenti futuri, e restituire i risultati ad un “cruscotto”, ovvero un pannello di controllo che assista i decisori a livello strategico oppure operativo.

Caso d’uso: IA per operatori SOC

I security operations center (SOC) rappresentano i “presidi di difesa cibernetica” di enti pubblici e imprese private. Gli operatori dei SOC si affidano estensivamente a sistemi di monitoraggio delle infrastrutture digitali quali Security Information and Event Management (SIEM) e Security Orchestration, Automation and Response (SOAR) per collezionare dati ed eventi e correlarli al fine di far emergere comportamenti anomali. L’integrazione all’IA in questi sistemi può fornire un supporto prezioso agli operatori dei SOC per contrastare attacchi informatici in modo più efficiente ed efficace, automatizzando le attività di risposta agli incidenti e coordinando le azioni degli operatori. Una delle principali applicazioni in cui l’IA viene utilizzata nei SOAR è l’automazione delle attività ripetitive e manuali. Ciò include l’esecuzione di azioni di mitigazione automatiche o l’attivazione di contromisure senza richiedere intervento umano, come l’isolamento di sistemi compromessi o la disattivazione di account sospetti. Questo permette agli operatori di concentrarsi su compiti più complessi e strategici, migliorando la produttività complessiva del SOC. Inoltre, i modelli di IA giocano un ruolo essenziale nel rilevamento tempestivo delle minacce e in particolare l’identificazione di pattern e comportamenti sospetti, anche tramite tecniche di anomaly detection [33]. Oltre all’analisi e al rilevamento, l’IA contribuisce alla gestione delle fasi di risposta agli incidenti o addirittura di crisi cibernetiche di ampio spettro attraverso la generazione di suggerimenti e raccomandazioni basate sui dati, fornendo agli operatori suggerimenti sulla gravità di un incidente, sulle azioni consigliate e sulle priorità. In quest’ottica, si potrebbe pensare ad un sistema di supporto alle decisioni sotto forma di chatbot realizzato da un motore di IA. Tale strumento consentirebbe di dotare gli operatori di un “crisis assistant” in grado di i) fornire rapidi riscontri (stile chatbot, appunto) durante l’evolversi del contesto d’attacco e difesa e ii) anche formulare un piano d’azione per contenere lo specifico incidente, basandosi su uno storico degli incidenti.

Caso d’uso: IA contro la disinformazione

L’utilizzo malevolo di alcuni sistemi di IA, in particolare quelli basati sui modelli generativi preaddestrati, permette di generare in modo massivo contenuti falsi, come notizie, immagini, audio o video (questi ultimi, anche noti come deepfake), che sembrano autentici. Questa possibilità consente di automatizzare (tipicamente a basso costo) attacchi su larga scala quali campagne di spam e phishing e campagne di disinformazione sulle reti sociali. D’altro canto, è possibile realizzare soluzioni innovative basate su IA anche per il contrasto alla disinformazione, in particolare in risposta alle due dimensioni principali di tale minaccia, la scala e la rapidità di diffusione, agendo a diversi stadi. Il primo di questi è il rilevamento, ovvero l’identificazione di pattern che distinguano le notizie false o artefatte da quelle vere localizzando la falsificazione sintetica degli elementi manipolati all’interno di foto, video e audio28. Inoltre, l’analisi delle reti di interazione sui social media e la verifica automatica della credibilità delle fonti, consentirebbero il tracciamento dell’informazione sospetta, il riconoscimento di botnet e la potenziale identificazione degli attori coinvolti. In ultimo è possibile utilizzare agenti intelligenti per implementare meccanismi di alerting preventivi e attivare i meccanismi di verifica di cui sopra con una latenza minima rispetto alla velocità di propagazione dei contenuti.

Conclusioni e sviluppi futuri

L’intelligenza artificiale e la cybersicurezza sono due aree che, come discusso, si intersecano su molteplici fronti. La cybersicurezza dei sistemi basati su IA e il potenziale utilizzo di questi sistemi a scopi offensivi sono tra le sfide più attuali e critiche dell’IA. D’altro canto, l’utilizzo di IA a supporto della cybersicurezza è certamente una grande opportunità per rendere automatiche, veloci e scalabili le strategie di risposta agli attacchi cyber, rendendo i sistemi di IA per la difesa un investimento da prevedere in maniera prioritaria. In questo articolo, a partire da un insieme di macro-processi di governo dell’IA&Cybersicurezza, abbiamo identificato attori, ruoli e oggetti che contribuiscono a garantire la cybersicurezza dell’ecosistema dell’IA. Dopo avere dettagliato i macro-processi, abbiamo illustrato altresì alcune applicazioni che mostrano scenari reali di IA&Cybersicurezza. Gli aspetti di valutazione del rischio, presentati nella Sezione 3.1, hanno una complessità intrinseca elevata e sono un importante esempio di come molte metodologie siano ancora sulla frontiera della ricerca. Come riportato nella roadmap 2022-2030 del progetto europeo flagship per l’IA TAILOR (Trustworthy Artificial Intelligence through Learning, Optimization and Reasoning) [34], bisogna consolidare le attività di ricerca in corso, rendere solide le teorie fondamentali e le linee guida metodologiche che non sono ancora comunemente utilizzate né nel mondo industriale né in quello accademico.

Tra i programmi di sviluppo e potenziamento sul fronte della ricerca e della innovazione in IA&Cybersicurezza descritti nella Sezione 3.5, evidenziamo l’importanza di avere un’adeguata capacità di calcolo nazionale per sfruttare pienamente i sistemi di IA sia a fini economici sia a fini sociali (cfr. rapporto dell’OECD [35]). Le crescenti esigenze di elaborazione dei sistemi di intelligenza artificiale creano una maggiore domanda di software, hardware e relativa infrastruttura, insieme alla forza lavoro qualificata necessaria per utilizzarli. Si pensi ad esempio che le capacità computazionali necessarie per fare training dei moderni sistemi di apprendimento automatico si è moltiplicata per centinaia di migliaia di volte dal 2012 [36]. Dal punto di vista della cybersecurity, la difesa da minacce cyber, anche nell’ottica di sviluppo di sistemi di IA “counter-AI”, comporta la necessità di poter (i) utilizzare infrastrutture ad elevate prestazioni di calcolo, quali ad esempio infrastrutture HPC2929, (ii) dotarsi di processi che permettano di sfruttare efficacemente tali infrastrutture, ad esempio facendo sì che aspetti di formazione, legali, di accesso e di ricerca siano definiti in un framework di governance che li contempli e li integri e (iii) assicurarne la resilienza, soprattutto in termini di autonomia strategica e sicurezza.

Per essere pronti a fronteggiare le sfide dell’IA&Cybersicurezza è necessario dotarsi di un’organizzazione strutturata e pianificare attività di governo dedicate. In questa direzione, il CISA degli Stati Uniti ha definito una “Roadmap for AI” [37] che, tra le varie linee di azione, identifica la collaborazione con gli attori del governo federale per avere una condivisione di intenti e azioni sul fronte IA&Cybersicurezza. L’ecosistema italiano di cybersicurezza può analogamente cominciare a strutturarsi e a dotarsi delle capacità necessarie a raccogliere le importanti sfide dell’IA&Cybersicurezza e a far sì che anche il nostro Paese possa beneficiare delle enormi potenzialità dell’intelligenza artificiale.

Bibliografia

[1] Università di Stanford, «AI Index 2023,» 2023. [Online]. Available: https://aiindex.stanford.edu/

[2] National Science and Technology Council, «National artificial intelligence research and development strategic plan – 2023 update,» 2023. [Online]. Available: https://www.whitehouse.gov/wp-content/uploads/2023/05/National-Artificial-Intelligence-Research-and-Development-Strategic-Plan-2023-Update.pdf

[3] White House Office of Science and Technology Policy, «Blueprint for an AI Bill of Rights: Making Automated Systems Work for the American People,» 2022. [Online]. Available: https://www.whitehouse.gov/wp-content/uploads/2022/10/Blueprint-for-an-AI-Bill-of-Rights.pdf.

[4] Commissione Europea, «L’intelligenza artificiale per l’Europa,» 2018. [Online]. Available: https://eur-lex.europa.eu/legal-content/IT/TXT/PDF/?uri=CELEX:52018DC0237&from=IT

[5] ENISA, «Artificial Intelligence and Cybersecurity Research,» 2023. [Online]. Available: https://www.enisa.europa.eu/publications/artificial-intelligence-and-cybersecurity-research

[6] Governo italiano, «Programma strategico – Intelligenza artificiale 2022-2024,» 2021. [Online]. Available: https://assets.innovazione.gov.it/1637937177-programma-strategico-iaweb-2.pdf

[7] ACN, «Agenda di Ricerca e Innovazione per la Cybersicurezza 2023-2026,» 2023. [Online]. Available: https://www.acn.gov.it/documents/agenda/it/ACN_ResearchInnovationAgenda.pdf

[8] S. Samoili, M. Lopez Cobo, E. Gomez Gutierrez, G. De Prato, F. Martinez-Plumed e B. Delipetrev, «AI Watch. Defining Artificial Intelligence,» 2020. [Online]. Available: https://publications.jrc.ec.europa.eu/repository/handle/JRC118163.

[9] ACN, «Strategia Nazionale di Cybersicurezza 2022-2026,» 2022. [Online]. Available: https://www.acn.gov.it/ACN_Strategia.pdf

[10] «DECRETO-LEGGE 14 giugno 2021, n. 82,» [Online]. Available: https://www.normattiva.it/uri-res/N2Ls?urn:nir:stato:decreto.legge:2021-06-14;82.

[11] NIST, «Artificial Intelligence Risk Management Framework (AI RMF 1.0),» 2023. [Online]. Available: https://nvlpubs.nist.gov/nistpubs/ai/NIST.AI.100-1.pdf

[12] NIST, «Crosswalk – An illustration of how NIST AI RMF trustworthiness characteristics relate to the OECD Recommendation on AI, Proposed EU AI Act, Executive Order 13960, and Blueprint for an AI Bill of Rights,» 2023. [Online]. Available: https://www.nist.gov/system/files/documents/2023/01/26/crosswalk_AI_RMF_1_0_OECD_EO_AIA_BoR.pdf

[13] ENISA, «Multilayer Framework for Good Cybersecurity Practices for AI,» 2023. [Online]. Available: https://www.enisa.europa.eu/publications/multilayer-framework-for-good-cybersecurity-practices-for-ai

[14] N. Carlini, M. Jagielsky, C. A. Choquette-Choo, D. Paleka, W. Pearce, H. Anderson, A. Terzis, K. Thomas e F. Tramèr, «Poisoning Web-Scale Training Datasets is Practical,» 2023. [Online]. Available: https://arxiv.org/pdf/2302.10149.pdf

[15] M. Fang, X. Cao, J. Jia e N. Gong, «Local Model Poisoning Attacks to Byzantine-Robust Federated Learning,» in 29th USENIX Security Symposium, 2020.

[16] T. Gu, B. Dolan-Gavitt e S. Garg, «BadNets: Identifying Vulnerabilities in the Machine Learning Model Supply Chain,» 2019. [Online]. Available: https://arxiv.org/pdf/1708.06733.pdf

[17] B. Chen, W. Carvalho, N. Baracaldo, H. Ludwig, B. Edwards, T. Lee, I. Molloy e B. Srivastava, «Detecting Backdoor Attacks on Deep Neural Networks by Activation Clustering,» 2018. [Online]. Available: https://arxiv.org/pdf/1811.03728.pdf

[18] A. Vassilev, A. Oprea, A. Fordyce e H. Anderson, «Adversarial Machine Learning: A Taxonomy and Terminology of Attacks and Mitigations. (National Institute of Standards and Technology, Gaithersburg, MD) NIST Artifcial Intelligence (AI) Report, NIST Trustworthy and Responsible AI NIST AI 100-2e2023,» 2024. [Online]. Available: https://nvlpubs.nist.gov/nistpubs/ai/NIST.AI.100-2e2023.pdf

[19] I. Shumailov, Y. Zhao, D. Bates, N. Papernot, M. R e R. Anderson, «Sponge Examples: Energy-Latency Attacks on Neural Networks,» in IEEE European Symposium on Security and Privacy (EuroS&P), Vienna, Austria, 2021.

[20] OECD, «Recommendation of the Council on Artificial Intelligence,» 2019. [Online]. Available: https://oecd.ai/en/assets/files/OECD-LEGAL-0449-en.pdf

[21] L. Taylor e G. Nitschke, «Improving Deep Learning with Generic Data Augmentation,» in IEEE Symposium Series on Computational Intelligence (SSCI), Bangalore, India, 2018.

[22] L. Truong, C. Jones, B. Hutchinson, A. August, B. Praggastis, R. Jasper, N. Nichols e A. Tuor, «Systematic Evaluation of Backdoor Data Poisoning Attacks on Image Classifiers,» in IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW), Seattle, WA, USA, 2020.

[23] S. Udeshi, S. Peng, G. Woo, L. Loh, L. Rawshan e S. Chattopadhyay, «Model Agnostic Defence Against Backdoor Attacks in Machine Learning,» IEEE Transactions on Reliability, vol. 71, n. 2, pp. 880-895, 2022.

[24] B. Wang, Y. Yao, S. Shan, H. Li, B. Viswanath, H. Zheng e B. Y. Zhao, «Neural Cleanse: Identifying and Mitigating Backdoor Attacks in Neural Networks,» in IEEE Symposium on Security and Privacy (SP), San Francisco, CA, USA, 2019.

[25] R. Baldoni, «Managing the cyber risk in a multipolar world,» International Journal of Critical Infrastructure Protection, vol. 39, n. 100578, pp. 1-3, 2023.

[26] ENISA, «Cybersecurity of AI and standardization,» 2023. [Online]. Available: https://www.enisa.europa.eu/publications/cybersecurity-of-ai-and-standardisation

[27] Commissione Europea, «COMMISSION IMPLEMENTING DECISION on a standardisation request to the European Committee for Standardisation and the,» 2023. [Online]. Available: https://ec.europa.eu/transparency/documents-register/detail?ref=C(2023)3215&lang=en

[28] EU Parliament, «China’s ambitions in artificial intelligence,» 2021. [Online]. Available: https://www.europarl.europa.eu/RegData/etudes/ATAG/2021/696206/EPRS_ATA(2021)696206_EN.pdf

[29] H. Roberts, M. Ziosi, C. Osborne, L. Saouma, A. Belias, M. Buchser, A. Casovan, C. Kerry, J. Meltzer, S. Mohit e M. E. Ouimette, «A Comparative Framework for AI Regulatory Policy,» 2023. [Online]. Available: https://ceimia.org/wp-content/uploads/2023/05/a-comparative-framework-for-ai-regulatory-policy.pdf

[30] NCSC, CISA, et al.,, «Guidelines for secure AI system development,» 2023. [Online]. Available: https://www.acn.gov.it/documents/Guidelines-for-secure-AI-system-development.pdf

[31] H. Janssen, «Generative AI: Security paradigm shift,» ENISA AI Cybersecurity Conference, 2023. [Online]. Available: https://www.enisa.europa.eu/events/2023-enisa-ai-cybersecurity-conference/huub-jansen-presentation-enisa-conference-rdi.pdf/view

[32] ENISA, «Cybersecurity Research Directions for the EU’s Digital Strategic Autonomy,» 2021. [Online]. Available: https://www.enisa.europa.eu/publications/cybersecurity-research-directions-for-the-eu2019s-digital-strategic-autonomy.

[33] A. B. Nassif, M. A. Talib, Q. Nasir e F. M. Dakalbab, «Machine Learning for Anomaly Detection: A Systematic Review,» IEEE Access, vol. 9, pp. 78658-78700, 2021.

[34] TAILOR, «Strategic Research & Innovation Roadmap of Trustworthy AI – The Scientific Foundations of Trustworthy AI in Europe for the Years 2022-2030,» [Online]. Available: https://tailor-network.eu/wp-content/uploads/2022/07/TAILOR-Roadmap-Full-Version-1.pdf.

[35] OECD, «A blueprint for building national compute capacity for artificial intelligence,» OECD Digital Economy Papers, 2023. [Online]. Available: https://www.oecd-ilibrary.org/docserver/876367e3-en.pdf?expires=1690191390&id=id&accname=guest&checksum=94EADBB2EF8203FEC9F16765ADD8494A.

[36] J. Sevilla, L. Heim, A. Ho, T. Besiroglu, M. Hobbhahn e P. Villalobos, «Compute Trends Across Three Eras of Machine Learning,» in International Joint Conference on Neural Networks (IJCNN), Padua, Italy, 2022, 2022.

[37] CISA, «CISA Roadmap for Artificial Intelligence,» 2023. [Online]. Available: https://www.cisa.gov/sites/default/files/2023-11/2023-2024_CISA-Roadmap-for-AI_508c.pdf.

[38] OECD, «Tools for trustworthy AI: A framework to compare implementation tools for trustweorthy AI systems,» OECD Digital Economy Papers, 2021. [Online]. Available: https://www.oecd-ilibrary.org/docserver/008232ec-en.pdf?expires=1690207133&id=id&accname=guest&checksum=2F0E59A18DFD2464AECFA73CE8F89567.

[39] ISO/IEC, «Information technology — Artificial intelligence (AI) — Bias in AI systems and AI aided decision making,» ISO/IEC TR 24027, 2021.

[40] ISO/IEC, «Information security management systems,» ISO/IEC 27001, 2022.

[41] NIST, «Security and Privacy Controls for Information Systems and Organizations,» NIST SP 800-53, 2020.

[42] ISO/IEC, «Information technology — Security techniques — Privacy framework,» ISO/IEC 29100:2011, 2011.

[43] M. F. Mridha, A. J. Keya, M. A. Hamid, M. M. Monowar e M. S. Rahma, «A Comprehensive Review on Fake News Detection With Deep Learning,» IEEE Access, vol. 9, pp. 156151-156170, 2021.

[44] A. P. Henriques de Gusmão, M. M. Silva, T. Poleto, T. L. Camara e Silva e A. P. Cabral Seixas Costa, «Cybersecurity risk analysis model using fault tree analysis and fuzzy decision theory,» International Journal of Information Management, vol. 43, pp. 248-260, 2018.

[45] M.-E. Paté-Cornell, M. Kuypers, M. Marshall e P. Keller, «Cyber Risk Management for Critical Infrastructure: A Risk Analysis Model and Three Case Studies,» Risk Analysis, vol. 38, n. 2, pp. 226-241, 2018.

[46] C. Foglietta e S. Panzieri, «Resilience in Critical Infrastructures: The Role of Modelling and Simulation,» in Issues on Risk Analysis for Critical Infrastructure Protection, IntechOpen, 2020.

[47] OWASP, «OWASP Top 10 for LLM,» 2023. [Online]. Available: https://owasp.org/www-project-top-10-for-large-language-model-applications/assets/PDF/OWASP-Top-10-for-LLMs-2023-v1_0.pdf.

- Disponibile, in inglese, al sito https://www.gov.uk/government/publications/ai-safety-summit-2023-the-bletchley-declaration/the-bletchley-declaration-by-countries-attending-the-ai-safety-summit-1-2-november-2023 ↩︎

- Disponibile, in inglese, al sito https://www.whitehouse.gov/briefing-room/presidential-actions/2023/10/30/executive-order-on-the-safe-secure-and-trustworthy-development-and-use-of-artificial-intelligence/ ↩︎

- Disponibile al sito https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX:52021PC0206 ↩︎

- Gruppo di esperti provenienti dal mondo accademico, dalla società civile e dall’industria nominato dalla Commissione nel 2018 con finalità consultive circa la strategia europea sull’IA, quali l’elaborazione di raccomandazioni sullo sviluppo di politiche future e sulle collegate questioni etiche, socio-economiche, legali e sociali ↩︎

- Nell’analisi, saranno considerate esclusivamente le minacce intrinsecamente riconducibili a debolezze “AI-specific” del ciclo di vita dei prodotti di IA. Saranno pertanto escluse quelle minacce che attengono a vulnerabilità che possono essere in gran parte mitigate da una corretta gestione della cybersicurezza dell’architettura complessiva del prodotto, quali, ad esempio, la corretta validazione dell’input, la prevenzione della manomissione dell’input/output utilizzando misure a livello di hardware, sistema operativo e software, controllo degli accessi, così come la sicurezza delle librerie responsabili dell’implementazione dell’algoritmo di IA. ↩︎

- Che ne preservino le caratteristiche di rappresentatività desiderate, e in particolare non introducano bias. ↩︎

- Come su esposto, i trigger utilizzati per le backdoor si basano su scorciatoie logiche all’interno del modello tra la previsione di output desiderata dall’attaccante (nell’esempio in Figura 3, la previsione limite di velocità) e l’input. Per trovare una scorciatoia, è necessario determinare, per ogni elemento del set di addestramento quale è la minima modifica da applicare per spostare sostanzialmente la previsione del modello. Se tale modifica è effettivamente di lievissima entità, si potrebbe essere in presenza di una backdoor [21]. Un metodo nel dominio del riconoscimento di immagini consiste nel mascherare in modo casuale parti di un’immagine di input ed esaminare come cambia la previsione del modello. Se l’immagine di input contiene un trigger, il mascheramento cambierà la previsione del modello [21]. ↩︎

- In particolare, conoscendone la funzione di minimizzazione dell’errore (loss function). ↩︎

- Ad esempio, utilizzando un meccanismo di “votazione” per scegliere come output la decisione adottata dalla maggioranza dei modelli. ↩︎

- Spesso, inoltre, modelli e dati sono mantenuti da operatori diversi. ↩︎

- Messi a disposizione, ad esempio, nell’ambito di servizi cloud. ↩︎

- Si veda la pagina https://certification.enisa.europa.eu/. ENISA sta elaborando tre schemi di certificazione per prodotti ICT, servizi cloud e reti 5G (denominati EUCC, EUCS e EU5G, rispettivamente). ↩︎

- Ad esempio, apparati elettronici e di telecomunicazioni ↩︎

- Per maggiori dettagli in materia si veda https://www.acn.gov.it/agenzia/organizzazione/cvcn ↩︎

- Sia in ottica di ottimizzazione di processi e procedure interne che allo scopo di sviluppare nuove soluzioni che incorporano prodotti basati su IA di terze parti. Ad esempio, una casa automobilistica potrebbe essere interessata ad integrare nell’auto un sistema di IA di terze parti funzionale all’implementazione di un sistema di guida autonoma. ↩︎

- Ad esempio, [40], [41] e [42]. ↩︎

- Si veda https://www.iso.org/committee/6794475.html ↩︎

- Al momento della scrittura di questo articolo, ventidue standard sono stati pubblicati. Si veda https://www.iso.org/committee/6794475/x/catalogue/p/1/u/0/w/0/d/0 ↩︎

- A questo riguardo, l’attività di iniziative no-profit a carattere di community quali, a titolo d’esempio, l’Open Web Application Security Project (OWASP), si presta ad essere più agile nello stare al passo con l’innovazione industriale, come testimoniato dal recente rapporto sulle principali dieci vulnerabilità dei LLM [47]. Pur non avendo l’autorevolezza di veri e propri enti o associazioni di standardizzazione, tali iniziative potrebbero essere di supporto per l’attività di questi ultimi. ↩︎

- Disponibile al sito https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX:52021PC0206 ↩︎

- L’impianto regolamentare prevede sinergie sia con il Cyber Resilience Act che con diverse normative settoriali, ad esempio, su trasporti e aviazione. ↩︎

- Negli artt. 1 e 2 della richiesta è fatta esplicita indicazione di tenere anche nella opportuna considerazione il lavoro svolto dall’ETSI in materia. ↩︎

- Attualmente in fase di Proposta. Si veda https://ec.europa.eu/info/law/better-regulation/have-your-say/initiatives/13410-Cyber-resilience-act-new-cybersecurity-rules-for-digital-products-and-ancillary-services_en ↩︎

- Disponibile al sito https://eur-lex.europa.eu/legal-content/EN/TXT/?uri=CELEX%3A52022PC0046 ↩︎

- Un esempio è l’istituzione dell’Artificial Intelligence Safety Institute (USAISI) istituito presso il NIST e del relativo consorzio, che prevede la collaborazione di enti pubblici, privati e accademia, per la creazione collaborativa di tecniche e metriche comprovate, scalabili e interoperabili per guidare gli sforzi del governo USA nella promozione, lo sviluppo e l’uso responsabile di un’intelligenza artificiale sicura e affidabile. ↩︎

- Si veda https://openai.com/blog/frontier-model-forum ↩︎

- A titolo d’esempio, [44], [45] e [46]. ↩︎

- Ad esempio, tramite reti neurali generative (Generative Adversarial Network, GAN) [43]. ↩︎

- ACN, in collaborazione con il consorzio CINECA, si sta dotando di tali infrastrutture, da mettere a disposizione del Paese sia per scopi industriali che di ricerca. ↩︎